在高速数据通信领域,Infiniband和以太网这两种主要的互连技术共同决定了数据中心和高性能计算 (HPC) 系统中数据流的流动方式。虽然两者都使用光模块来实现快速稳定的传输,但它们的设计要求、性能目标和应用场景却存在显著差异。了解这些差异有助于工程师和系统设计人员选择合适的收发器解决方案,以实现最佳性能和成本效益。

1. Infiniband 和以太网的本质

以太网是企业和云环境使用的通用网络标准。它优先考虑兼容性、可扩展性和成本控制。Infiniband另一方面,它专为超低延迟和高带宽而设计,使其成为超级计算中心、AI集群和HPC网络。

简单来说,以太网“广泛而通用”,而Infiniband“快速而专注”。两者都依赖于光模块,但对光模块的要求却大相径庭。

2.带宽和延迟要求

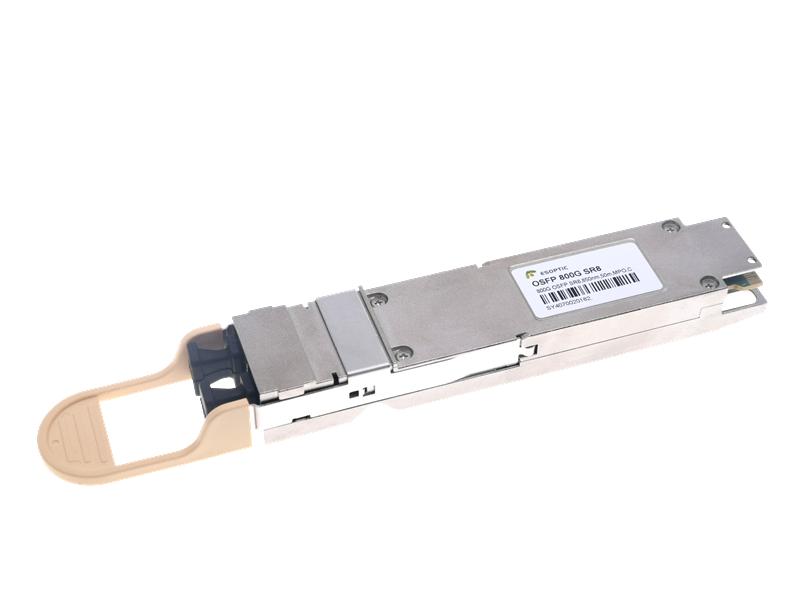

Infiniband支持 HDR (200Gb/s)、NDR (400Gb/s) 甚至 XDR (800Gb/s) 等数据速率。其延迟可低至微秒,非常适合需要实时数据同步的工作负载。

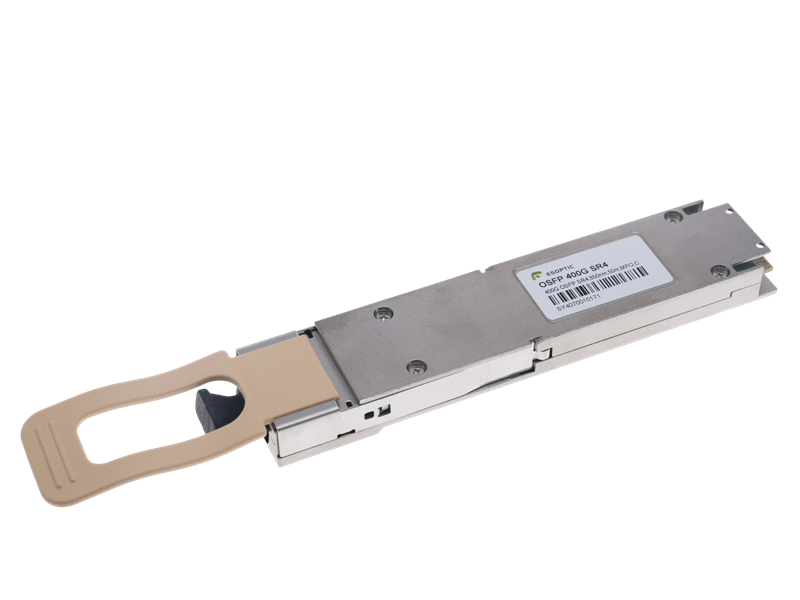

以太网100G、400G、800G 等光模块专注于平衡的性能和互操作性。延迟略高,但以太网网络更易于扩展并与现有基础设施集成。

在光学,我们的高速光模块(包括 200G/400G/800G 系列)旨在满足以太网数据中心要求和Infiniband HPC标准,确保不同网络架构下的稳定性和精确性。

3. 协议和信号完整性

这Infiniband协议需要更严格的信号完整性和链路质量控制。为Infiniband设计的光模块必须保持一致的低BER(误码率)和严格的抖动性能。

相比之下,以太网模块强调多供应商兼容性、自动协商能力和标准化外形尺寸,例如QSFP56、QSFP-DD 和 OSFP。

4. 应用场景

Infiniband:HPC 集群、超级计算网络、AI 训练平台和科学模拟。

以太网:云数据中心、企业网络、5G回程和大规模存储互连。

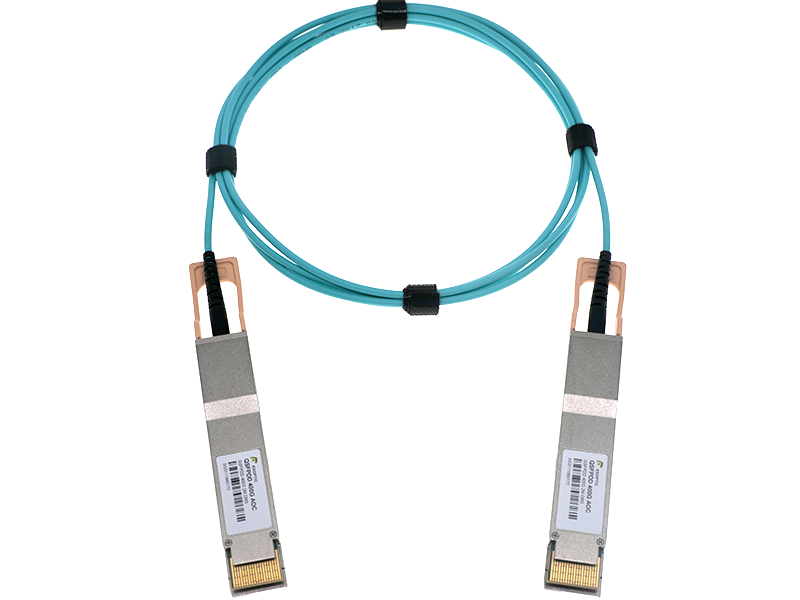

在光学,我们提供针对两个生态系统优化的收发器模块和 AOC/DAC 电缆解决方案 - 确保跨混合基础设施的无缝互连。

5.成本和维护

以太网光模块受益于大规模生产和标准化,从而降低成本并更容易部署。

Infiniband模块然而,它们更加专业化,需要高级光学元件来保持其超低延迟和可靠性,从而导致价格更高,但在 HPC 环境中性能无与伦比。

结论

比较时Infiniband 与以太网,关键在于应用需求:

如果你寻求极快的速度和最小的延迟,Infiniband 是未来的发展方向。

如果你优先考虑灵活性、可扩展性和通用兼容性,以太网仍然是主要选择。

光学继续提供适用于 Infiniband 和以太网系统的光学模块——弥合 HPC 性能和数据中心效率之间的差距。

常问问题

1. Infiniband 相对于以太网的主要优势是什么?

Infiniband 为 HPC 和 AI 工作负载提供更低的延迟、更高的吞吐量和卓越的性能。

2. 以太网能在高性能环境中取代Infiniband吗?

不完全是。以太网可以处理大规模通信,但无法与Infiniband的微秒级延迟相媲美。

3.Infiniband光模块与以太网系统兼容吗?

一般来说不会。它们在不同的协议下运行,尽管 ESOPTIC 为混合架构提供了兼容的解决方案。

4.为什么Infiniband模块更贵?

他们使用更高等级的光学元件和更严格的质量控制来满足低延迟、高可靠性的要求。

5.ESOPTIC如何确保两个系统的模块性能?

通过严格的质量测试、高速信号分析、以及针对每个协议的定制设计优化。